Circuit Breaker e Padrões de Resiliência: Construindo Sistemas que Falham Graciosamente

Em sistemas distribuídos, falhar não é uma possibilidade, é um destino. Seja um serviço sobrecarregado, uma rede instável ou um banco de dados que atingiu o limite de conexões, algo vai dar errado em algum momento. O grande desafio da arquitetura moderna não é impedir a falha, mas sim garantir que, quando ela aconteça, ela não leve o sistema inteiro para o abismo. Sem as proteções certas, um erro pequeno em um serviço periférico pode se propagar como um efeito dominó, resultando no temido "colapso em cascata" (cascade failure).

É aqui que o conceito de Circuit Breaker entra em cena. Inspirado nos disjuntores que protegem nossas casas, esse padrão atua como uma válvula de segurança crítica para serviços distribuídos. Dominar esse e outros mecanismos de resiliência é o que separa um sistema frágil de uma infraestrutura capaz de absorver impactos e continuar operando com dignidade.

1. Anatomia de uma Cascade Failure

1.1 Como Falhas se Propagam

Imagine que o Serviço A chama o Serviço B, e B está lento (não falhando completamente, apenas lento). As threads de A ficam esperando respostas de B. Conforme mais requisições chegam a A, mais threads ficam bloqueadas. Eventualmente, todas as threads de A estão esperando B, e A para de responder a qualquer requisição — incluindo aquelas que não dependem de B. Agora outros serviços que dependem de A também começam a falhar. A lentidão de um único serviço se transformou em colapso total.

O padrão é insidioso porque o serviço problemático original (B) pode nem parecer tão ruim. Talvez esteja lento mas respondendo. Mas a lentidão acumula: se cada requisição leva 10 segundos em vez de 100ms, você precisa 100x mais threads (que você não tem) para manter o mesmo throughput. Timeouts muito longos (ou inexistentes) agravam o problema.

1.2 A Necessidade de Proteção

A proteção precisa ser no chamador, não no chamado. O Serviço B não sabe que está causando problemas a A; do ponto de vista de B, ele está processando requisições (lentamente) normalmente. A é quem precisa se proteger, decidindo que se B está problemático, é melhor falhar rápido do que esperar indefinidamente. Esta é a premissa central do Circuit Breaker.

2. O Padrão Circuit Breaker

2.1 Estados do Circuit Breaker

O Circuit Breaker opera em três estados. Fechado (Closed): estado normal, requisições são passadas para o serviço downstream. O breaker monitora a taxa de falhas. Aberto (Open): após a taxa de falhas exceder um threshold, o breaker "abre" — requisições falham imediatamente sem tentar contatar o serviço downstream. Isso protege o chamador e dá tempo ao serviço problemático para se recuperar. Meio-Aberto (Half-Open): após um período de tempo, o breaker permite uma requisição de teste. Se ela suceder, o breaker fecha e retorna à operação normal. Se falhar, o breaker abre novamente.

A máquina de estados é simples mas eficaz. Veja a visualização do fluxo:

stateDiagram-v2

[*] --> Closed

Closed --> Open : Failure Rate > Threshold

Open --> HalfOpen : Wait Duration Elapsed

HalfOpen --> Closed : Success Rate > Threshold

HalfOpen --> Open : FailureA configuração crítica é: quantas falhas ou que porcentagem de falhas disparam a abertura? Quanto tempo o circuito permanece aberto antes de tentar novamente? Essas decisões dependem das características do serviço downstream e dos requisitos de negócio.

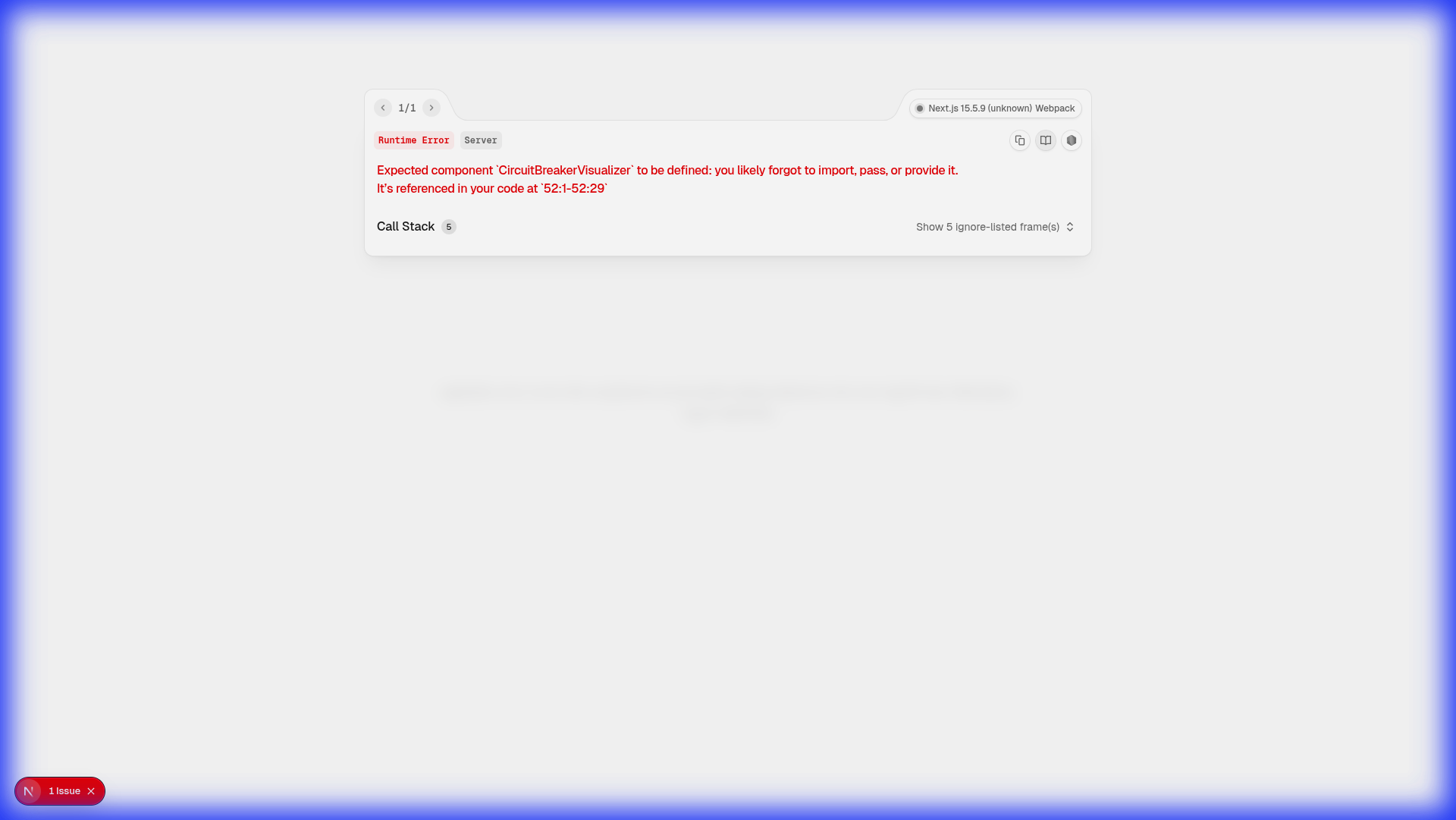

Simulador de Circuit Breaker

Clique nos botões para simular o comportamento

Sistema operando normalmente. As requisições são permitidas.

Live Logs

2.2 Benefícios do Circuit Breaker

Fail Fast: Quando o circuito está aberto, falhas são instantâneas. Isso libera recursos que seriam desperdiçados esperando um serviço que não vai responder, permitindo que o sistema degrade graciosamente. Backpressure Automático: Ao parar de enviar requisições para um serviço sobrecarregado, você dá a ele chance de se recuperar. Empilhar mais requisições só piora a situação. Monitoramento: O estado do circuit breaker é um sinal operacional valioso. Dashboards mostrando circuitos abertos imediatamente alertam sobre problemas de dependências.

2.3 Implementações Populares

Hystrix (Netflix, agora em modo de manutenção) foi a implementação que popularizou o padrão na era de microsserviços. Resilience4j é o sucessor moderno para Java, com design funcional e menor footprint. Polly é a biblioteca de escolha para .NET. Istio e outros service meshes implementam circuit breaking na camada de proxy, transparente para a aplicação.

3. A Matemática da Resiliência: Janelas Deslizantes

Um Circuit Breaker não toma decisões baseadas em uma única falha. Ele precisa de um contexto histórico, e é aqui que entram as Sliding Windows (Janelas Deslizantes). Existem duas implementações principais:

3.1 Count-based Sliding Window

Nesta abordagem, o breaker analisa as últimas $N$ requisições.

- Implementação: Geralmente utiliza um Ring Buffer (ou array circular).

- Vantagem: É determinístico. Se a janela é de 100 requisições e o threshold é 50%, o circuito abre exatamente na 51ª falha consecutiva.

- Ponto de Atenção: Em sistemas com tráfego muito baixo, pode levar horas para preencher a janela, tornando a reação lenta.

3.2 Time-based Sliding Window

Analisa as falhas ocorridas nos últimos $T$ segundos.

- Implementação: Divide o tempo em buckets (ex: 10 segundos divididos em 10 buckets de 1 segundo). Conforme o tempo passa, o bucket mais antigo é descartado e um novo é criado.

- Vantagem: É ideal para lidar com a natureza temporal das falhas de rede.

- Ponto de Atenção: Exige mais memória e processamento para gerenciar a expiração dos buckets.

3.3 O Algoritmo de Adaptive Concurrency Limits

Uma evolução do Circuit Breaker fixo é o Adaptive Concurrency Limit. Em vez de definir "50% de erro", o sistema monitora o tempo de resposta (RTT - Round Trip Time) e utiliza algoritmos inspirados no controle de congestionamento do TCP (como o Vegas ou Gradient). Se o RTT subir acima da média histórica, o sistema reduz o limite de requisições simultâneas (o Bulkhead) automaticamente, antes mesmo de ocorrerem erros 5xx.

4. Padrões Avançados de Resiliência

3.1 Timeouts

O timeout é o mecanismo de proteção mais básico e essencial em qualquer sistema distribuído. Toda chamada a um serviço externo deve ter um timeout definido — nunca espere indefinidamente por uma resposta que pode nunca vir. Sem timeouts, requisições para serviços lentos ou indisponíveis podem ficar pendentes indefinidamente, consumindo recursos do sistema (threads, conexões, memória) e potencialmente levando ao esgotamento desses recursos.

A escolha do valor do timeout é crucial e requer análise cuidadosa do comportamento do serviço chamado. Um timeout muito curto pode causar falsos positivos, interrompendo operações legítimas que simplesmente levam mais tempo que o esperado. Por outro lado, um timeout muito longo não protege adequadamente o sistema chamador, permitindo que recursos fiquem bloqueados por períodos excessivos.

Idealmente, os timeouts devem ser baseados em percentis observados do tempo de resposta real do serviço (por exemplo, P95 ou P99 + uma margem de segurança), e não em suposições teóricas. Esses valores devem ser monitorados e ajustados continuamente à medida que o desempenho do serviço evolui. Em arquiteturas modernas, diferentes endpoints ou operações podem ter timeouts diferentes, refletindo suas características específicas de latência. Ajustar timeouts de forma dinâmica com base em métricas de desempenho em tempo real é uma prática avançada que melhora significativamente a resiliência do sistema.

4.2 Retry com Backoff e Jitter

Quando uma requisição falha, é tentador tentar novamente imediatamente. Mas se a falha foi causada por sobrecarga, retry imediato gera um cenário de Thundering Herd (manada barulhenta).

Estratégia Recomendada:

- Exponential Backoff: $wait = base_time \times 2^n$

- Jitter: Adicione um valor aleatório ao tempo de espera para evitar que milhares de clientes retentem no mesmo milissegundo.

// Exemplo de Jitter no algoritmo

const waitTime = Math.min(maxWait, (baseTime * Math.pow(2, attempt)) + Math.random() * 1000);4.3 Bulkhead: Isolamento por Thread Pool vs Semaphore

Existem duas formas de implementar o Bulkhead:

- Thread Pool: Isola completamente o serviço em um conjunto de threads dedicado. Se o pool encher, novas requisições são rejeitadas. É o mais seguro, mas consome mais memória.

- Semaphoro: Apenas limita o número de conexões simultâneas. É mais leve, mas não protege contra latências extremas que deixam as threads presas.

4.4 Fallback: A Arte do Plano B

Fallbacks são estratégias de contingência que permitem que o usuário nem perceba que houve uma falha no sistema. Eles são componentes críticos da resiliência, pois garantem que o sistema continue funcionando, mesmo que em um estado degradado, em vez de simplesmente falhar completamente. Um fallback bem projetado oferece uma experiência degradada, mas funcional, mantendo o usuário engajado e evitando a frustração de uma experiência interrompida.

Exemplos práticos de fallbacks incluem:

- Serviço de Recomendação fora do ar? Retorne os produtos mais vendidos ou mais populares como padrão. Isso mantém a experiência de navegação ativa mesmo sem personalização em tempo real.

- Serviço de Preço Real-time falhou? Use o último preço cacheado (dados obsoletos, mas ainda úteis). Embora não reflita mudanças imediatas, permite que o usuário continue navegando e tomando decisões com base em informações razoavelmente atuais.

- Checkout falhou? Salve a intenção de compra e avise o usuário que ele receberá um e-mail de confirmação em breve (processamento assíncrono). Isso transforma uma falha imediata em uma transação pendente que pode ser processada quando o sistema estiver disponível novamente.

- API de Mapas indisponível? Mostre uma imagem estática do mapa ou uma representação simplificada baseada em dados armazenados localmente.

- Serviço de Análise estatística offline? Use dados históricos armazenados localmente ou mostre mensagens genéricas de desempenho até que o serviço esteja disponível novamente.

A implementação de fallbacks eficazes requer planejamento cuidadoso. Primeiro, você deve identificar quais pontos de falha críticos precisam de planos alternativos. Em seguida, determine qual é a experiência degradada aceitável para cada caso. O fallback deve ser implementado de forma a ser acionado automaticamente quando o circuit breaker abrir ou quando uma chamada falhar, garantindo continuidade de serviço com o mínimo de interrupção.

Além disso, é importante monitorar e medir a frequência com que os fallbacks são acionados. Se um fallback está sendo usado com muita frequência, isso pode indicar um problema mais profundo no serviço principal que precisa ser resolvido. O fallback é uma solução temporária de resiliência, não uma substituição permanente para um serviço confiável.

5. Transações Distribuídas e o Padrão Saga

Quando falamos de resiliência em sistemas que envolvem múltiplos bancos de dados, o Circuit Breaker sozinho não basta. Se o serviço de Pagamento falha após o serviço de Estoque ter reservado o produto, como voltamos atrás?

O Padrão Saga resolve isso através de uma sequência de transações locais:

- Orquestração: Um centralizador coordena as chamadas. Se houver falha, ele chama as "Transações Compensatórias" (Rollback lógico).

- Coreografia: Cada serviço publica eventos. Se o serviço B falha, ele emite um evento de "Falha", e o serviço A (que ouve esse evento) executa sua compensação.

Nesse cenário, o Circuit Breaker atua na tentativa de cada passo da Saga. Se o circuito para o serviço de Pagamento está aberto, a Saga nem tenta a transação e já inicia o processo de compensação imediatamente, economizando recursos preciosos.

6. Resiliência na Era do Service Mesh

Com a arquitetura de microsserviços, mover a lógica de resiliência da aplicação para a infraestrutura tornou-se tendência.

5.1 Outlier Detection (Circuit Breaker Passivo)

Proxies como o Envoy (usado no Istio) implementam o Outlier Detection. Ele monitora o sucesso e a latência de cada instância (pod) em um cluster. Se uma instância específica começa a falhar mais que as outras, o proxy a remove temporariamente do balanceamento de carga. Diferente do Circuit Breaker clássico (que protege o serviço como um todo), o Outlier Detection protege contra o "nó doente" no cluster.

5.2 Fault Injection e Chaos Engineering

Ferramentas modernas permitem injetar falhas na rede sem mudar uma linha de código:

- Delay Injection: Adiciona latência artificial de 500ms em 10% das chamadas para testar timeouts.

- Abort Injection: Retorna HTTP 500 em 5% das chamadas para validar o comportamento do Circuit Breaker.

7. Monitoramento e Observabilidade

Você não pode "setar e esquecer" um Circuit Breaker. É vital monitorar:

- State Transitions: Quantas vezes o circuito abre por hora?

- Circuit Recovery Time: Quanto tempo o serviço leva para se recuperar?

- Fallback Success Rate: O plano B está funcionando ou ele também está falhando?

Dashboards no Grafana usando métricas do Prometheus (como resilience4j_circuitbreaker_state) são essenciais para o time de SRE.

7.1 Tabela Comparativa de Estratégias

| Estratégia | Objetivo | Quando Usar | Custo | | :--- | :--- | :--- | :--- | | Timeout | Limitar espera | Sempre (obrigatório) | Baixo | | Retry | Corrigir falha transiente | I/O instável, rede | Alto (CPU/Rede) | | Circuit Breaker | Evitar sobrecarga | Serviço fora do ar | Médio (Memória) | | Bulkhead | Isolar falhas | Dependências críticas | Alto (Recursos) | | Fallback | Garantir resposta | UI, UX crítica | Variável |

8. Implementação Prática: Resilience4j

Para quem trabalha com Java/Spring Boot, o Resilience4j é o padrão de ouro. Veja como configurar um breaker de forma profissional:

8.1 Configuração YAML (application.yml)

resilience4j.circuitbreaker:

instances:

backendService:

registerHealthIndicator: true

slidingWindowSize: 100

minimumNumberOfCalls: 10

permittedNumberOfCallsInHalfOpenState: 3

automaticTransitionFromOpenToHalfOpenEnabled: true

waitDurationInOpenState: 5s

failureRateThreshold: 50

eventConsumerBufferSize: 10

recordExceptions:

- org.springframework.web.client.HttpServerErrorException

- java.io.IOException

ignoreExceptions:

- io.github.resilience4j.circuitbreaker.CallNotPermittedException8.2 Exemplo em Código Java

@CircuitBreaker(name = "backendService", fallbackMethod = "fallback")

public String doSomething() {

return restTemplate.getForObject("/external-api", String.class);

}

public String fallback(Exception e) {

return "Resposta Alternativa: Serviço temporariamente indisponível";

}8.2 O que Conta como Falha?

Definir "falha" não é trivial. Timeout óbviamente conta. HTTP 5xx geralmente conta. Mas e HTTP 4xx? Um 400 Bad Request é problema do cliente, não do serviço — provavelmente não deveria contar. Um 429 Too Many Requests indica que o serviço está sobrecarregado — deveria contar. Exception types, response times acima de threshold, e outros sinais podem ser incorporados.

8.3 Testando Resiliência: Chaos Engineering

Mecanismos de resiliência devem ser testados antes de serem necessários. Netflix popularizou "Chaos Engineering" — injetar falhas propositalmente em produção para validar que o sistema se comporta conforme esperado. Ferramentas como Chaos Monkey (desliga instâncias aleatoriamente), Toxiproxy (simula problemas de rede), e Gremlin permitem testes controlados de resiliência.

9. Resiliência de Baixo Nível: eBPF e o Futuro

Uma das fronteiras mais excitantes da resiliência é o uso de eBPF (Extended Berkeley Packet Filter). O eBPF permite que você injete lógica de resiliência diretamente no kernel do Linux, sem que os pacotes sequer cheguem à sua aplicação.

- Kernel-level Circuit Breaking: O kernel pode monitorar o TCP reset rate de um destino e bloquear a conexão antes de gastar qualquer recurso do Data Plane (Envoy) ou da aplicação.

- Zero-latency Observabilidade: Como roda no kernel, o custo de medir cada microssegundo de latência é praticamente zero, permitindo thresholds muito mais agressivos e precisos.

10. Estudo de Caso: O Buraco Negro do GitHub (2018)

Em 2018, o GitHub sofreu uma queda de 24 horas devido a uma falha na replicação do banco de dados MySQL após uma manutenção de rede. O que tornou o incidente tão longo foi o Cascade Failure. Mesmo após a rede voltar, o volume de requisições acumuladas "atropelou" as instâncias que tentavam subir. Se o sistema tivesse Circuit Breakers e Adaptive Concurrency Limits mais agressivos na camada de borda, o tráfego teria sido "podado" automaticamente, permitindo que os bancos de dados fizessem o recovery de forma isolada e muito mais rápida.

11. Resiliência na Nuvem: AWS, Azure e Google Cloud

Cada provedor de nuvem possui suas próprias implementações e recomendações para o padrão Circuit Breaker:

- AWS App Mesh: Utiliza o Envoy para injetar políticas de circuit breaking e outliers detection de forma transparente em clusters EKS ou instâncias EC2.

- Azure Service Fabric: Possui suporte nativo para serviços confiáveis com mecanismos de retry e circuit breaking embutidos no SDK.

- Google Cloud Anthos (Service Mesh): Oferece uma camada de controle robusta para gerenciar a resiliência em ambientes multi-cloud, permitindo que o mesmo circuit breaker funcione de forma idêntica no GKE e no On-premise.

11.1 Checklist de Produção: Você está pronto?

Antes de colocar seu Circuit Breaker em produção, valide estes 10 pontos:

- [ ] Timeout Definido: Toda chamada externa tem um limite de tempo (não confie no default da biblioteca).

- [ ] Threshold Baseado em Dados: O limite de erro foi definido com base na telemetria real do serviço.

- [ ] Fallback Implementado: Existe um plano B que não depende de outro serviço instável.

- [ ] Alertas Configurados: O time de SRE recebe uma notificação quando um circuito importante abre.

- [ ] Logs de Transição: As mudanças de estado (Closed -> Open) estão sendo registradas.

- [ ] Metric Export: As métricas do breaker estão chegando no Prometheus/Grafana.

- [ ] Teste de Carga: O breaker foi testado sob estresse para garantir que ele não consome CPU excessiva.

- [ ] Idempotência: Os retries são seguros e não causam duplicidade de dados no destino.

- [ ] Conformidade em Half-Open: O breaker não deixa passar tráfego demais no estado de teste.

- [ ] Chaos Monkey: Uma falha real foi injetada para validar que o sistema degrada graciosamente.

12. FAQ: Perguntas Frequentes (Expandido)

1. O Circuit Breaker deve ser usado em chamadas para o Banco de Dados? Sim, especialmente se o banco for uma dependência externa (como um DBaaS). No entanto, o threshold deve ser muito baixo, pois um banco lento geralmente indica que o pool de conexões já está no limite.

2. Qual a diferença entre Circuit Breaker e Retry? O Retry tenta recuperar uma falha momentânea (ex: glitch de rede). O Circuit Breaker impede que você continue tentando quando a falha é estrutural (ex: serviço fora do ar).

3. Posso usar Circuit Breaker em chamadas síncronas? Sim, é onde ele é mais útil. Em chamadas assíncronas (filas), o próprio mecanismo de requeue da fila atua como uma forma de resiliência, mas o breaker ainda pode ser usado para parar o "consumer" se o destino estiver fora.

4. O que é o 'Half-Open' state? É o estado de teste. O sistema deixa passar uma pequena quantidade de tráfego para verificar se o serviço remoto voltou a operar normalmente antes de fechar o circuito totalmente.

5. O Circuit Breaker adiciona latência? Mínima. A lógica de verificação de estado ocorre em memória (geralmente um bit check ou contador atômico). É ordens de magnitude mais rápido que uma chamada de rede.

6. Como configurar o threshold de erro? Para serviços críticos, 50% é o padrão da indústria. Para serviços menos tolerantes, você pode baixar para 10% ou 20%.

7. O que é 'Bulkhead'? É a técnica de dividir os recursos (threads, conexões) em compartimentos estanques para que a falha em um não se espalhe para os outros.

8. Posso ter um Circuit Breaker Global? Geralmente não é recomendado. O ideal é ter um breaker por "comando" ou por dependência, para que você não pare de vender só porque o serviço de sugestão de CEP caiu.

9. Como o Hystrix difere do Resilience4j? O Hystrix usava sua própria hierarquia de thread pools, o que era pesado. O Resilience4j usa Java 8 Lambdas e Functional Programming, sendo muito mais leve e modular.

10. O que é 'Self-Healing'? É a capacidade do sistema de se recuperar sozinho. O estado Half-Open do Circuit Breaker é um exemplo clássico de mecanismo de auto-recuperação.

11. O Circuit Breaker funciona em APIs REST? Sim, ele mapeia códigos HTTP (como 503 e 504) como sinais de abertura de circuito.

12. Devo logar cada falha do Circuit Breaker? No estado OPEN, logar cada falha causaria um "log flood". O ideal é logar apenas as transições de estado (ex: "Circuito mudou de CLOSED para OPEN").

13. O que acontece se o meu Fallback também falhar? Aí a falha é propagada para o usuário. Por isso, fallbacks devem ser o mais simples e seguros possível (geralmente sem chamadas de rede).

14. Como testar o Circuit Breaker? Use ferramentas de Chaos Engineering para simular latência ou erros 5xx e observe se o circuito abre conforme configurado.

15. O Circuit Breaker substitui o Timeout? Nunca. O Timeout é o gatilho, e o Circuit Breaker é a estratégia de contenção. Eles trabalham juntos.

16. O que é 'Graceful Degradation'? É a capacidade do sistema de continuar funcionando com funcionalidades reduzidas quando partes dele falham.

17. Posso usar Circuit Breaker no Frontend?

Sim, bibliotecas como o opossum ou implementações customizadas ajudam o frontend a não travar a UI esperando uma API lenta.

18. Qual o papel do SRE no tuning do Circuit Breaker? O SRE analisa as métricas de tráfego e erro para ajustar os thresholds e garantir que o sistema não seja nem muito sensível (aberturas falsas) nem muito lento para reagir.

19. O que é 'Time-based Sliding Window'? É uma janela de monitoramento que olha os erros dos últimos X segundos, em vez de olhar a média das últimas N requisições.

20. O que acontece com as requisições quando o circuito está OPEN?

Elas são rejeitadas instantaneamente com uma exceção (como CallNotPermittedException no Resilience4j), sem sequer tocar a rede.

21. O que é 'Jitter'? É um componente aleatório adicionado ao tempo de espera entre retries para evitar que todos os clientes "batam" no servidor ao mesmo tempo.

22. O que é 'Exponential Backoff'? Uma técnica onde você dobra o tempo de espera a cada falha consecutiva (ex: 1s, 2s, 4s, 8s...).

23. Circuit Breaker ajuda contra ataques DDoS? Não diretamente. Ele protege a sua aplicação de ficar travada, mas não impede a carga de chegar ao seu balanceador de carga.

24. O que é o 'Outlier Detection' do Envoy? É uma forma de circuit breaking que remove instâncias específicas de um cluster de balanceamento de carga se elas estiverem performando pior que a média.

25. Como o Circuit Breaker lida com erros 4xx? Geralmente, erros 4xx (como 404 ou 400) são ignorados pelo breaker, pois indicam erro do cliente ou dados não encontrados, não instabilidade do servidor.

26. Posso forçar um circuito a abrir manualmente? Sim, a maioria das bibliotecas e meshes oferecem um "Admin Override" para situações de emergência.

27. O que é 'Adaptive Concurrency Limited'? Uma técnica avançada que ajusta o limite de requisições simultâneas baseada na latência observada, em vez de um número fixo.

28. Como o Circuit Breaker impacta o Cache? Em caso de circuito aberto, um fallback comum é servir dados do cache (stale content), aumentando a resiliência sentida pelo usuário.

29. O que é 'Cascade Failure'? É o efeito dominó onde a falha de um serviço consome recursos do chamador, derrubando-o, e assim por diante.

31. O Circuit Breaker deve ser usado em chamadas assíncronas (RabbitMQ/Kafka)? Sim, para sinalizar ao sistema de monitoramento que o serviço de destino está indisponível, mesmo que a fila atue como um buffer natural de resiliência.

32. Qual a relação entre Circuit Breaker e 'Pressure Relief'? O Circuit Breaker é um tipo de Pressure Relief que alivia a pressão sobre um sistema em colapso permitindo que ele "respire" sem novas requisições.

33. É possível ter Circuit Breakers hierárquicos? Sim, você pode ter um breaker para uma API inteira e breakers específicos para cada endpoint, permitindo uma granularidade maior no controle de falhas.

15.2 Resiliência em Redes Móveis (Edge Computing)

Em aplicações móveis, a falha não é exceção, é a regra (túneis, elevadores, troca de antenas). Nestes casos, o Circuit Breaker no lado do cliente (App Android/iOS) deve ser muito mais agressivo e estar intimamente ligado ao estado de conectividade do sistema operacional para evitar drenagem de bateria tentando chamadas impossíveis.

34. Janelas Deslizantes grandes demais são ruins? Sim. Se a janela for muito grande (ex: 1 hora), o breaker pode demorar muito para "perceber" que o serviço caiu agora. O ideal são janelas curtas e reativas (10s a 60s).

- Netflix Tech Blog. Fault Tolerance in a High Volume, Distributed System.

- Google SRE Book. Handling Overload.

- SoundCloud. Building a Resilient Service Mesh.

- Lyft Engineering. Introducing Envoy Proxy.

Livros Recomendados

- Ford, N. (2020). Fundamentals of Software Architecture. O'Reilly.

- Richardson, C. (2018). Microservices Patterns. Manning.

- Humble, J., & Farley, D. (2010). Continuous Delivery. Addison-Wesley.

14. A Física da Resiliência: A Velocidade da Luz e o Mundo Real

Muitas vezes esquecemos que a comunicação entre microsserviços está sujeita às leis da física. Se o seu serviço está em São Paulo (AWS sa-east-1) e sua dependência está na Virgínia (AWS us-east-1), a latência mínima teórica de ida e volta (RTT) é de cerca de 120ms devido à velocidade da luz na fibra óptica.

- Impacto nos Timeouts: Configurar um timeout de 100ms para uma chamada transcontinental garantirá que o seu circuito esteja sempre aberto (falso positivo).

- Localização de Fallbacks: Se o seu fallback exigir outra chamada de rede para uma região distante, você está apenas multiplicando o problema de latência. O fallback ideal é sempre local ou cacheado.

15. A Psicologia da Engenharia de Resiliência

Por que muitos times evitam implementar Circuit Breakers até que seja tarde demais?

- Otimismo Prematuro: "Nosso serviço nunca caiu antes".

- Medo do Desconhecido: "E se o breaker abrir por engano e pararmos de processar vendas legítimas?"

- Complexidade Visual: Thresholds e janelas deslizantes parecem complicados de tunar.

A solução é começar pequeno. Ative o Circuit Breaker em modo Monitor-only (onde ele loga o que faria, mas não abre o circuito) e analise os logs por uma semana. Quando você ganhar confiança de que o breaker só dispararia em cenários de desastre real, mude para o modo ativo.

Referências Acadêmicas e Técnicas

- Hamilton, J. (2007). On Designing and Deploying Internet-Scale Services.

- Vogels, W. (2009). Eventually Consistent. ACM Queue. (Werner Vogels, CTO da Amazon, discute como falhas são a regra em escala).

- Dekker, S. (2011). Drift into Failure. Ashgate Publishing. (Sobre como sistemas complexos falham gradualmente).

- Allspaw, J. (2012). Fault Injection in Production.

- Fowler, M. (2014). Circuit Breaker. martinfowler.com.

16. Conclusão

Construir sistemas resilientes exige uma mudança de mentalidade: precisamos parar de tentar prever todas as falhas e começar a projetar sistemas que saibam como reagir a elas. O Circuit Breaker, aliado a timeouts bem definidos, retries inteligentes e fallbacks amigáveis, forma o arsenal necessário para garantir que o seu sistema não seja apenas funcional, mas robusto.

No final das contas, resiliência não é sobre nunca cair, mas sobre como você se levanta — e como você garante que um tropeço em um serviço não derrube toda a sua infraestrutura. Em produção, esses padrões não são um luxo; são a diferença entre uma noite de sono tranquila e um incidente crítico generalizado.

Glossário de Termos

Backoff Exponencial: Aumento progressivo do tempo de espera entre tentativas.

Bulkhead: Técnica de isolamento de recursos inspirada em divisórias navais.

Cascade Failure: Fenômeno de falhas que se propagam em série por um sistema.

Chaos Engineering: Disciplina de injetar falhas para fortalecer a resiliência.

Circuit Breaker: Mecanismo que interrompe o fluxo de requisições preventivamente.

Closed State: Estado operacional normal do circuit breaker.

Open State: Estado de bloqueio total de requisições.

Half-Open State: Estado de convalescença, testando o serviço remoto.

Fallback: Plano de contingência para falhas de chamadas externas.

Jitter: Aleatoriedade introduzida para quebrar o sincronismo de retries.

Timeout: Limite máximo de tempo para a conclusão de uma operação.

Sliding Window: Período de tempo ou número de chamadas usado para cálculos.

Resilience4j: Biblioteca moderna de resiliência para o ecossistema Java.

Service Mesh: Rede de proxies que gerencia comunicação entre serviços.

Saga Pattern: Padrão para transações distribuídas baseadas em compensação.

Outlier Detection: Identificação e isolamento de instâncias com performance irregular.

Thundering Herd: Problema de muitos clientes retentando conexões simultaneamente.

Self-Healing: Sistemas que detectam e corrigem falhas automaticamente.

Graceful Degradation: Manutenção de funcionalidades básicas sob falha.

7. Apêndice B: Referências

- Nygard, M. (2007). Release It! Design and Deploy Production-Ready Software. Pragmatic Bookshelf.

- Netflix Engineering Blog. Making the Netflix API More Resilient.

- Resilience4j Documentation. resilience4j.readme.io.

- Microsoft Azure Architecture. Circuit Breaker pattern.

- Kleppmann, M. (2017). Designing Data-Intensive Applications. O'Reilly.

- Newman, S. (2015). Building Microservices. O'Reilly.

Este artigo foi desenvolvido com base em documentação técnica e práticas da indústria.